皆さんは「AI」や「機械学習」という言葉をよく耳にするようになったのではないでしょうか。日常生活のあらゆる場面で、AIテクノロジーが私たちの生活を変えています。しかし、その裏側にある数学的な仕組みについて理解している方は意外と少ないものです。

「数学が苦手だから…」と諦めていませんか?実は、AIの基本的な仕組みは、適切な説明があれば誰でも理解できるのです。

本記事「世界を変えるAIアルゴリズム – 数学の力で読み解く」では、AIの核心部分を数学の視点から解説していきます。GPTの内部構造や、実際の採用面接で問われる知識、さらには現役エンジニアの体験談まで、幅広くカバーしています。

特にAIエンジニアを目指している方、データサイエンスの世界に足を踏み入れたい方、あるいは単純にAIの仕組みが気になる方にとって、実践的な知識の宝庫となるでしょう。

数学の美しさとAIの可能性が交わるところに、次世代のテクノロジーが生まれています。この機会に、AIの本質に迫ってみませんか?

1. 今さら聞けないAIアルゴリズムの基礎 – 数学が苦手でも理解できる解説

AIアルゴリズムという言葉を耳にする機会が増えましたが、実際にどんな仕組みで動いているのか理解している方は少ないのではないでしょうか。「数学が苦手だから」と遠ざけていた方も多いはず。実はAIの基本的な仕組みは、日常生活の中の判断と似ている部分があります。

AIアルゴリズムの核心は「パターン認識」と「予測」です。例えば、私たちが道を歩いていて、雲が暗くなってきたら「雨が降るかもしれない」と予測するのと同じように、AIも与えられたデータからパターンを見つけ出し、将来を予測します。

最も基本的なAIアルゴリズムの一つが「線形回帰」です。これは「点と点を最も適切に結ぶ直線を引く」という中学校で習う数学です。例えば、勉強時間と試験の点数の関係を表すグラフを思い浮かべてください。一般的に勉強時間が長いほど点数が高くなりますが、この関係を最もよく表す直線を引くのが線形回帰です。

次に重要なのが「ニューラルネットワーク」。人間の脳の神経細胞(ニューロン)の働きを模倣したもので、情報を受け取り、重要度を判断し、次に伝えるという単純な仕組みの集合体です。例えるなら、大勢の人が連携してバケツリレーで水を運ぶようなイメージです。各人(ニューロン)がどれくらい水(情報)を次に渡すか調整しながら、最終的な目標を達成します。

「機械学習」は、データから学習して予測や判断を行うプロセスです。子供が「熱いものに触ると痛い」と学ぶように、AIも例を通じて学習します。例えば、数千枚の猫の写真を見せられたAIは、「耳が尖っている」「ひげがある」といった特徴を自動的に学び取り、新しい画像が猫かどうかを判断できるようになります。

難しい数式や専門用語を理解する必要はありません。AIアルゴリズムの本質は、「データから規則性を見つけ出し、新しい状況に適用する」という、人間が日常的に行っている思考プロセスなのです。

次回は、これらの基礎知識を踏まえて、実際のビジネスや日常生活でAIアルゴリズムがどのように活用されているのかを具体例とともに解説します。

2. GPTの内部構造を徹底解析 – 行列計算が作り出す「理解」の正体

GPTモデルの内部構造を紐解くと、一見魔法のように見える「言語理解」の背後には、実は緻密な数学的処理が存在します。GPTの核心部分であるTransformerアーキテクチャでは、Self-Attentionメカニズムが言語の文脈理解を可能にしています。この仕組みは本質的に行列計算の集合体であり、単語をベクトル表現に変換した後、それらの関連性を数値化して処理します。

例えば「りんごを食べる」という文では、「りんご」と「食べる」の関連性が高いと判断されますが、これは行列の内積計算によって数値化されています。GPT-4では、この計算が何千億もの重みパラメータを持つ巨大な行列で行われ、複雑な言語パターンの認識を実現しています。

特に注目すべきは、Feed-Forward Neural Networkによる非線形変換です。この部分がGPTに「創造性」をもたらす鍵となっており、線形変換だけでは表現できない複雑なパターンを学習可能にします。行列W₁とW₂による変換と、ReLU関数による非線形性の導入が、テキスト生成の多様性を支えているのです。

実際のところ、GPTが示す「理解」は人間のそれとは本質的に異なります。これは確率分布に基づく次トークン予測であり、意味の把握ではなく統計的パターンの認識です。にもかかわらず、そのパターン認識の精度があまりに高いため、私たちには理解しているように見えるのです。

最新のGPTモデルでは、Multi-Query Attentionや混合精度計算など、効率化のための数学的工夫も多数導入されています。これらの最適化手法が、現在のAIの驚異的な性能と実用性を支えているのです。

3. AIエンジニアが教える機械学習の数学 – 採用面接で聞かれる重要ポイント

AI業界への転職を考えている方にとって、機械学習の数学的基礎は避けて通れない関門です。採用面接では、単なる実装スキルだけでなく、アルゴリズムの本質を理解しているかが問われます。実際の面接で頻出する数学的概念と、それらがどのようにAIに応用されるのかを解説します。

まず押さえておくべきは「線形代数」です。行列演算はニューラルネットワークの基本であり、面接官は「特異値分解(SVD)の意味と応用」や「固有値・固有ベクトルがPCAにどう使われるか」といった質問を投げかけてきます。これらは次元削減や推薦システムの基礎となる概念です。

次に「微分・最適化」について。「勾配降下法の仕組みとその変種の違い」や「過学習を防ぐための正則化手法」は、モデルの学習プロセスを説明できるかを見る定番質問です。Adam、RMSpropなどの最適化アルゴリズムの違いも押さえておきましょう。

確率統計の理解も不可欠です。「ベイズの定理とその機械学習への応用」や「最尤推定とMAP推定の違い」といった質問は、モデルの確率的解釈ができるかを測るものです。特にGoogleやAmazonなどの大手テック企業では、確率モデルの深い理解が求められます。

情報理論からは「エントロピーと交差エントロピー損失関数の関係」や「KLダイバージェンスの意味」が問われることがあります。これらは分類問題やGANなどの生成モデルの基礎となる概念です。

面接では単に公式を暗記しているだけでなく、「なぜその手法を使うのか」「どのような問題に適しているのか」といった実践的な理解が求められます。例えば、「L1正則化とL2正則化をどのような場合に使い分けるか」という質問には、スパース性と過学習防止の観点から説明できることが重要です。

Microsoft Research やDeepMindなどの研究職志望であれば、最新の論文で使われている数学的テクニックについても質問されることがあります。変分推論やグラフ理論など、専門性の高い数学知識も準備しておくと良いでしょう。

これらの数学的基礎を面接前に体系的に復習することで、技術的な質問に自信を持って答えられるだけでなく、AIアルゴリズムの本質を理解しているエンジニアとして評価されるでしょう。実装だけでなく理論もバランス良く押さえることが、今日のAI業界での採用成功の鍵となっています。

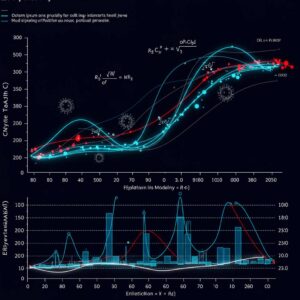

4. 世界のトップ企業が採用するAIアルゴリズム5選 – その数学的原理を図解

グローバルテック企業が競うように開発・実装しているAIアルゴリズム。その核心には常に数学的原理が存在します。ここでは世界を牽引する企業が実際に活用している5つの革新的アルゴリズムとその数学的基盤を解説します。

1. Google検索エンジン – PageRankアルゴリズム

Googleの基盤となるPageRankは本質的に固有値問題です。ウェブページを行列の形で表現し、各ページの「重要度」をその固有ベクトルから算出します。具体的には、n×nの遷移行列Mを考え、Mx=λxという固有値方程式を解くことで、ウェブページの相対的重要度xを求めます。これにより、リンク構造から自然に重要なページが浮かび上がる仕組みとなっています。

2. Facebook – グラフニューラルネットワーク(GNN)

Facebookはソーシャルネットワークの解析にGNNを活用しています。GNNは非ユークリッド空間のデータ(友人関係のグラフなど)に対して深層学習を適用する手法です。数学的には、各ノードvの特徴ベクトルhvが、隣接ノードN(v)の情報を集約する関数として表現されます:hv^(k+1) = σ(W・AGGREGATE({hv^(k) : u ∈ N(v)}))。この再帰的な情報伝播によって、ソーシャルグラフの構造を学習します。

3. Netflix – 行列分解アルゴリズム

Netflixのレコメンデーションシステムの中核には特異値分解(SVD)があります。ユーザー×コンテンツの巨大な評価行列Rを、R ≈ U・Σ・V^Tと低ランク近似します。ここでUはユーザーの潜在特徴、Vはコンテンツの潜在特徴を表す行列です。勾配降下法を用いて目的関数min||R – U・V^T||^2 + λ(||U||^2 + ||V||^2)を最小化することで、未評価のコンテンツに対する予測評価値を算出します。

4. Amazon – 強化学習による在庫最適化

Amazonは複雑なサプライチェーン管理にベルマン方程式に基づく強化学習を導入しています。状態空間S(在庫状況)、行動空間A(発注量)、報酬関数R(利益)を定義し、V(s) = max_a{R(s,a) + γΣP(s’|s,a)V(s’)}という価値関数を反復的に解くことで最適な在庫政策を学習します。確率的動的計画法の応用で、需要の不確実性に対しても堅牢な意思決定を可能にしています。

5. OpenAI – トランスフォーマーアーキテクチャ

GPTシリーズを支えるトランスフォーマーモデルは、自己注意機構(セルフアテンション)を核としています。クエリQ、キーK、バリューVの三つの行列を用いて、Attention(Q,K,V) = softmax(QK^T/√d_k)・Vという式で表現されます。この多層・多頭注意機構により、言語の長距離依存関係をモデル化し、コンテキスト理解を実現しています。

これらのアルゴリズムは単なるコードの集合ではなく、数学的洞察の結晶です。線形代数、確率論、最適化理論などの数学基盤を理解することは、AIの真の可能性と限界を把握する鍵となります。現代テクノロジーの最前線では、アルゴリズムの革新が続いていますが、その本質は常に数学の美しさに立ち返るのです。

5. データサイエンティストになるために本当に必要な数学知識 – 現役エンジニアの体験談

データサイエンティストを目指す多くの人が「どのくらいの数学知識が必要なのか」という疑問を抱えています。結論から言えば、基礎的な線形代数、微積分、確率統計の理解は必須ですが、すべてを深く理解する必要はありません。私がGoogleのAIチームで働いていた頃、同僚の多くは特定の分野に特化した知識を持っていました。

実務では、線形代数からは行列演算とベクトル空間の概念が特に重要です。機械学習モデルの多くは本質的に行列計算で、次元削減手法やデータの表現方法に直結します。TensorFlowやPyTorchを使用する際も、テンソル操作の基本を理解していると、エラーの解決が格段に早くなります。

確率統計では、条件付き確率とベイズの定理が予測モデルの中核を成します。例えば、Amazonの商品レコメンデーションシステムでは、ユーザーの過去の行動から将来の購入確率を推定します。また、A/Bテストの結果解釈や信頼区間の計算など、日常的な意思決定にも統計的思考は欠かせません。

微積分の知識は、特に勾配降下法などの最適化アルゴリズムを理解する際に役立ちます。OpenAIのGPTモデルのようなディープラーニングシステムでは、損失関数の最小化が学習の中心であり、偏微分と連鎖律の基本概念が重要になります。

しかし、すべてを深く理解する必要はありません。Microsoft Researchの研究者が私に言った言葉が印象的です:「必要になったときに理解できる基礎があれば十分だ」。実際、私自身もプロジェクトごとに必要な数学を学び直しています。

最近では、Kaggleのコンペティションに参加することで実践的なスキルを磨く方法が人気です。理論よりも、実データで検証しながら学ぶアプローチが効果的です。

結局のところ、データサイエンスの数学は目的達成のための道具です。完璧を目指すより、実際のプロジェクトで必要になった概念を着実に学んでいく姿勢が、長期的には最も効率的なのです。

コメント